Nya publikationer

Kardiologer har tränat en stor AI-modell för att bedöma hjärtats struktur och funktion

Senast recenserade: 02.07.2025

Allt iLive-innehåll är mediekontrollerat eller faktiskt kontrollerat för att säkerställa så mycket faktuell noggrannhet som möjligt.

Vi har strikta sourcing riktlinjer och endast länk till välrenommerade media webbplatser, akademiska forskningsinstitut och, när det är möjligt, medicinsk peer granskad studier. Observera att siffrorna inom parentes ([1], [2] etc.) är klickbara länkar till dessa studier.

Om du anser att något av vårt innehåll är felaktigt, omodernt eller på annat sätt tveksamt, välj det och tryck på Ctrl + Enter.

Experter på artificiell intelligens vid Cedars-Sinai och Smidt Heart Institute skapade en datauppsättning med mer än 1 miljon ekokardiogram (videoultraljud av hjärtat) och deras motsvarande kliniska tolkningar. Med hjälp av denna databas utvecklade de EchoCLIP, en kraftfull maskininlärningsalgoritm som kan "tolka" ekokardiogrambilder och bedöma viktiga mätvärden.

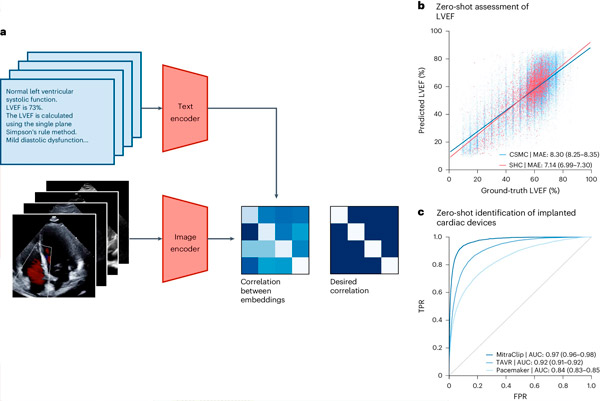

Utformningen och utvärderingen av EchoCLIP, som beskrivs i en artikel publicerad i Nature Medicine, tyder på att tolkning av en patients ekokardiogram med hjälp av EchoCLIP ger kliniska bedömningar på specialistnivå, inklusive bedömning av hjärtfunktion, resultat från tidigare operationer och implanterade enheter, och kan hjälpa läkare att identifiera patienter i behov av behandling.

EchoCLIP-basmodellen kan också identifiera samma patient i flera videor, studier och tidpunkter, och känna igen kliniskt viktiga förändringar i patientens hjärta.

"Så vitt vi vet är detta den största modellen som tränats på ekokardiografibilder ", säger huvudförfattaren till studien David Ouyang, MD, en fakultetsmedlem vid avdelningen för kardiologi vid Smidt Heart Institute och avdelningen för artificiell intelligens i medicin.

"Många tidigare AI-modeller för ekokardiogram är endast tränade på tiotusentals exempel. Däremot är EchoCLIPs unikt höga prestanda inom bildtolkning resultatet av träning på nästan tio gånger mer data än befintliga modeller."

"Våra resultat visar att stora datamängder av medicinsk avbildning och expertverifierade tolkningar kan fungera som grund för att träna grundläggande medicinska modeller, vilka är en form av generativ artificiell intelligens", tillade Ouyang.

EchoCLIP-arbetsflöde. Källa: Nature Medicine (2024). DOI: 10.1038/s41591-024-02959-y

Han noterade att denna avancerade baslinjemodell snart skulle kunna hjälpa kardiologer att utvärdera ekokardiogram genom att generera uppskattningar av hjärtmätningar, identifiera förändringar över tid och vanliga sjukdomar.

Forskargruppen skapade en datauppsättning med 1 032 975 ultraljudsvideor av hjärtat och motsvarande experttolkningar för att utveckla EchoCLIP. De viktigaste resultaten från studien inkluderar:

- EchoCLIP visade hög prestanda vid bedömning av hjärtfunktion från hjärtbilder.

- Baslinjemodellen kunde identifiera implanterade intrakardiella enheter såsom pacemakers, mitralisimplantat och aortaklaffimplantat från ekokardiogrambilder.

- EchoCLIP identifierade korrekt unika patienter i olika studier, upptäckte kliniskt viktiga förändringar såsom tidigare hjärtkirurgi och möjliggjorde utveckling av preliminära texttolkningar av ekokardiogrambilder.

”Grundläggande modeller är ett av de nyaste områdena inom generativ AI, men de flesta modeller har inte tillräckligt med medicinska data för att vara användbara inom sjukvården”, säger Christina M. Albert, MD, MPH, ordförande för avdelningen för kardiologi vid Smidt Heart Institute.

Albert, som inte var involverad i studien, tillade: "Denna nya baslinjemodell integrerar datorseende för tolkning av ekokardiogrambilder med naturlig språkbehandling för att förbättra kardiologers tolkningar."